https://huggingface.co/tiiuae/Falcon3-10B-Instruct-1.58bit

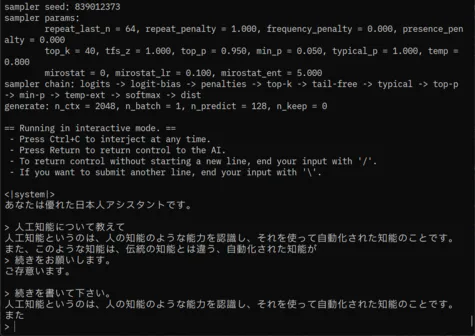

Falcon3-10B-Instruct-1.58bitというBitNetモデルが賢いらしいと聞いたので、今慌てて評価してるところ。

BitNetの推論アプリはllama.cppの改造版なので、-pに指定した日本語が通らんとか、めんどくささがある。

それとバイナリがCPU版だから遅いなぁ。自分でビルドしなきゃいけないか。軽い評価だけならCPUでもいけるが、10Bモデルだと1.58bit量子化モデルといえ、3GB超えるし、そこそこ遅いんだよね。

llama.cppのcliで日本語通すにはどうすればいいんだっけ。ああうざい…

https://x.com/EzoeRyou/status/1868744046140875122

https://x.com/EzoeRyou/status/1868744304392650931

https://x.com/EzoeRyou/status/1868755016066224412

私も概ね、同じ想像をしてるんだけど、AI使ってますアピールだとしてもむしろ逆効果な程、質が低いと思うんだよね…。

かといって、これ以上の計算資源を注いだら多分コストが高すぎて無理だろうし、そもそもLLMにRAGなんていう(実は)高度なタスクは厳しいと私は思ってる。

「AIによる概要」は、ほっといても自滅するとは思うんだけど、テコ入れして延命する可能性もあるかな。そこはGoogleさんのいつものサービス損切り判断の早さに期待したいところ。

https://ja.wikipedia.org/wiki/踏切障害物検知装置

赤外線とかレーザーとかよりはカメラの方が安い。そんなもんなのね。

https://news.mynavi.jp/article/20241217-3088432/

踏切障害物検知装置より、普通のカメラ+AI物体検出システムの方が安いのか。

障害物検知装置ってもっと安価なのかと思ってた…

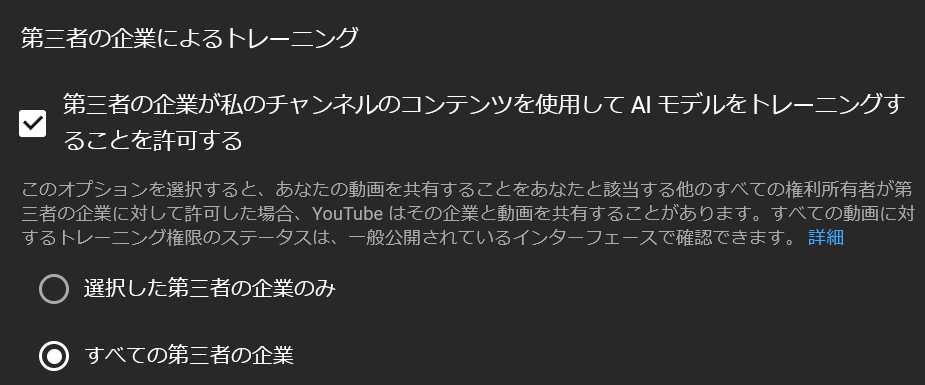

https://gigazine.net/news/20241217-youtube-opt-out-ai-training/

デフォルトはオフなんだそうだ。じゃあこの学習許可設定はオプトインなのか。

…ん?じゃあOpenAIはSoraをどうやって学習したんだ…(

https://x.com/Mega_Gorilla_/status/1869044156334764106

YouTubeにはAI企業別に学習データ提供をオプトアウトする機能がついてるらしい。

一律禁止じゃなくて、ユーザーの意思に委ねるのは面白いな。でもそうあるべきかもしれない。

(ところでGoogle自身が学習することについてのオプトアウトは、やっぱりないんですかね?)

https://x.com/AIatMeta/status/1869072205839245812

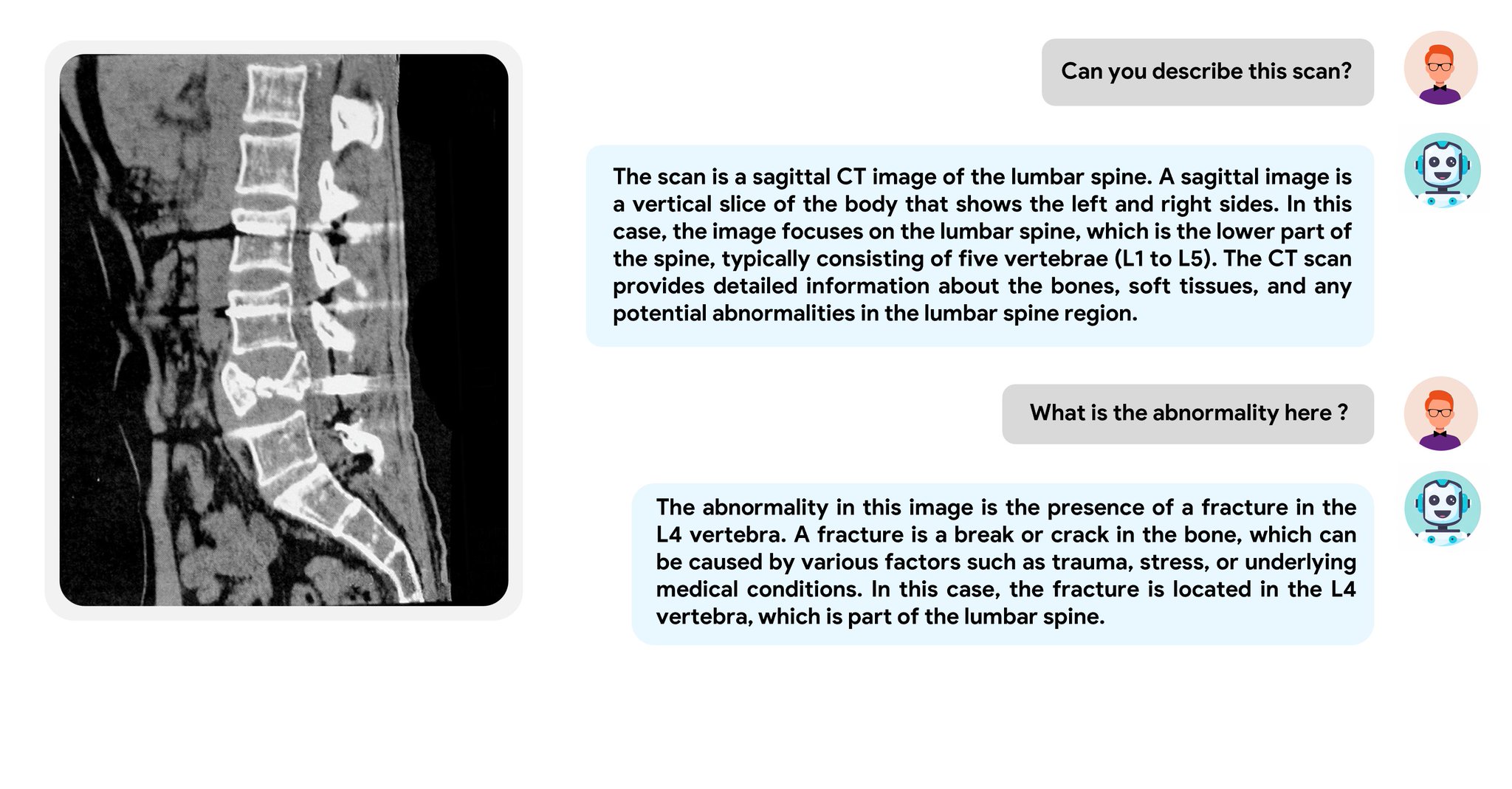

医用画像をVLMに読ませることの嬉しさってどれくらいあるんだろう。VLMの精度を考えれば、こんな誰が見ても腰の骨が折れてると分かる写真に、腰の骨が折れてますよ、と指摘できるのが関の山ではないか?

そして、その診断を下せるのは医師のみだし、誰が見ても分かる病変を医師が分からない筈もない。

画像診断AIの有用性は分かるんだよね。あれは、大量の画像を学習することで、人間の認知能力とは異なるパターン認識が可能となり、人間では見つけるのが困難な病変を発見できる、という明確なメリットがあるので。

ただ、このポストのVLMはアラビア語-英語のハイブリッドらしいんで、医師が患者に説明する際の翻訳機として使うことを想定しているのかもしれない。

https://zenn.dev/kendama/articles/32aa9ec4bed409

LLMに長文書かせるのに、まず段落分けさせて、次に各段落を埋めさせる手法がある。

でもモデル自体を長文対応に学習させるのがめんどいよね。

これまで書いた文をコンテキストにそのまま載せるんじゃなくて、これまで書いた文の要約をまず作り、それを載せていくようにすると、モデル学習不要で長文書かせられるのでお勧め。

要約が増えたら、「要約の要約」のように再帰的に圧縮していったり、要約をローテーションしたり、不要な要約(たとえば最初と直前の章以外)をマスクしたり、などの工夫をすれば、事実上、無限コンテキスト窓が得られるよ。

https://platform.openai.com/docs/api-reference/chat/create

今ちょっとo1のAPI仕様をみてたんだけど、reasoning専用のエントリポイントって無いんだ。普通にchat completionを使う。ただし、o1用にいくつかパラメータが増えてた。

reasoning_effortを指定することで、思考時間(思考にかけるトークン数)を制限かけられるみたい。ただし、low,medeium,highというアバウトな指定しかできない。

あと、戻り値にreasoning_tokensプロパティが追加されてて、これでreasoningに要したトークン数が取得できるようだ。

一つ気になるのは、ChatGPTにはある、reasoningの要約を表示する機能が、APIには無さそうな気がする。だとしたら困るんじゃないか?